2024.04.04 20:25 更新

2024.04.04 取材

日本AMD株式会社(本社:東京都千代田区)は2024年4月4日、メディア向け説明会「AI MEDIA BRIEFING」を開催。AMD本社からAI戦略を統括するVictor Peng氏が来日し、AIに関連するハードウェア製品と、それを活かすソフトウェアについて解説を行った。

|

|

| AMD本社から来日にしたVictor Peng氏。AMDの前はXilinxで14年間勤務し、FPGAやSoC、GPU、ハイパフォーマンスCPUなどの分野に精通している | |

2023年から一気に普及した感のあるAIだが、当初はクラウドやデータセンターなどで行う大規模言語モデルでの運用が中心だった。しかし、最近ではエッジデバイスや、クライアントPCなどのいわゆるエンドポイントでもAIの運用が広がってきており、この流れは今後もさらに加速していくだろう。

|

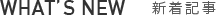

| AMDでは、大規模データセンターからエッジやクライアント向けのエンドポイント向けまで幅広いAI製品をラインナップ |

そんな中、AMDでは大規模なデータセンターやクラウド向けの「Instinct MI300X」を筆頭に、エンタープライズ向けの「EPYC」、ゲーム・クリエイティブ向けの「Radeon RX/Pro 7000」、組み込み向けのVersal AI Edge、コンシューマ向けCPUの「Ryzen AI」まで幅広いラインナップを揃えており、あらゆるシーンでのAI化に貢献できる点をメリットとして挙げていた。

|

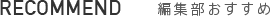

そして、これらのハードウェアの中でも特にAMDがアピールしていたのが、昨年12月に発表されたAIアクセラレータ「Instinct MI300X」だ。

|

「Instinct MI300X」は、NVIDIA H100の対抗として開発された製品で、CDNA 3アーキテクチャを採用する8基のXCDダイや、256MBのInfinity Cacheを備えた4基のI/Oダイ、192GBのHBM3メモリなどを高速なInfinity Fabric Linkで連結したチップレット構成を採用。また3D Hybrid Bondedと2.5D silicon interposerのパッケージ技術を組み合わせることで1チップに統合している。

これにより、AI処理でボトルネックになりやすいメモリ容量やメモリ帯域の問題を解決している。さらに大規模な演算処理を行った場合でも無駄なデータの移動を最小限に抑えることができ、消費電力を削減できる効果も期待できるという。

|

なお「Instinct MI300X」には、バリエーションモデルとして2基のXCDダイの代わりに、Zen 4世代のCPUを内蔵したAI処理/HPC向け初のAPU「Instinct MI300A」もラインナップしている。

|

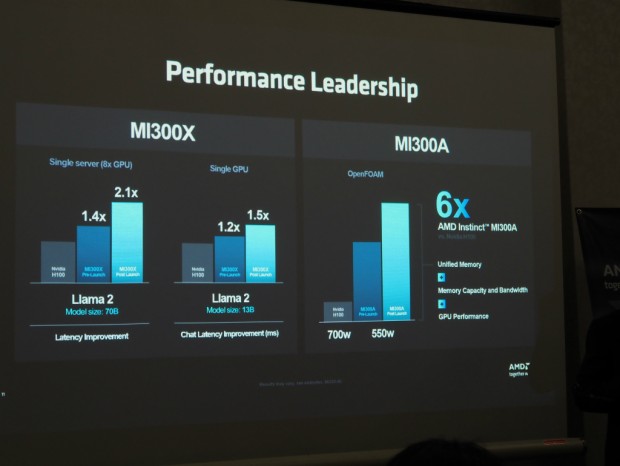

| AMDでは、ラウンチ後もソフトウェアの最適化を進めており、ラウンチ前から大きく性能が向上しているとのこと |

ちなみにAMDの資料によれば、Llama 2 70Bの処理ではNVIDIA H100との比較で、ラウンチ前の計測で1.4倍、ラウンチ後のコンパイラやランタイム、ライブラリの最適化により2.1倍、Llma 2 13Bの処理でもラウンチ前の計測で1.2倍、ラウンチ後では1.5倍の性能を発揮するなど良好なパフォーマンスを記録している。

|

|

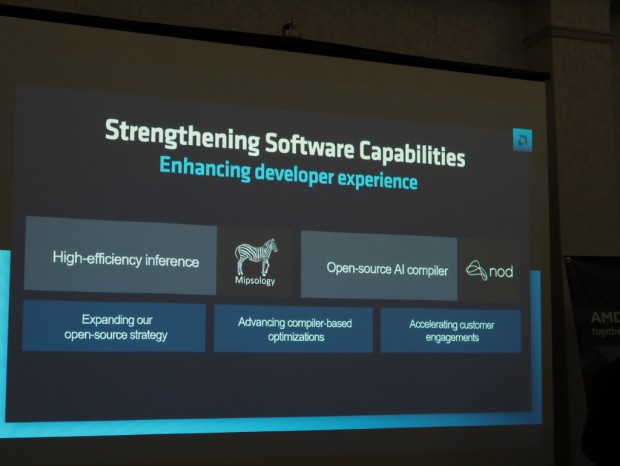

| AMDではAI関連のソフトウェア開発を強化するため、積極的に企業の買収も行っている |

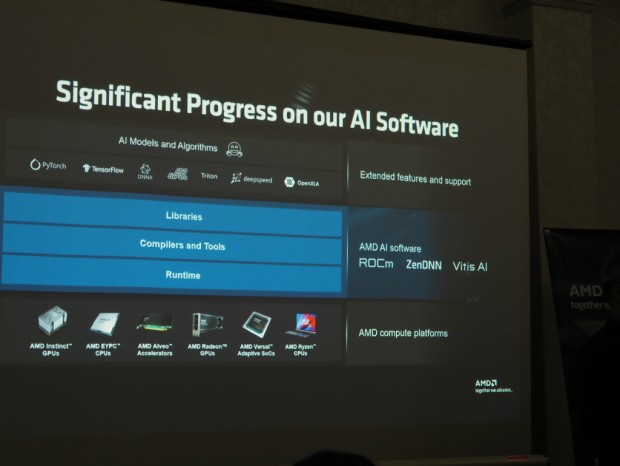

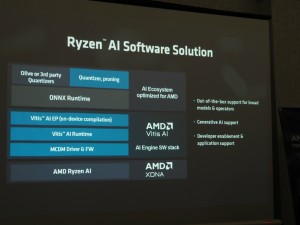

そしてAMDでは、ハードウェアだけでなく、それを活かすためのソフトウェアにも注力しており、AMDのAIデバイスで動作するライブラリやコンパイラ、ランタイムとして、GPU向けの「ROCm」、CPU向けの「ZenDNN」、FPGA向け「Vitis AI」をリリースしている。これらはいずれもオープンソースとして提供されているため、アプリケーションの開発が簡単に行えるだけでなく、品質や信頼性を担保できるというメリットもある。

|

|

|

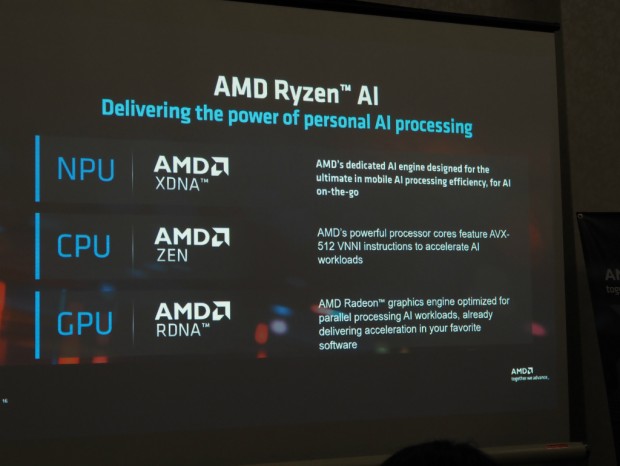

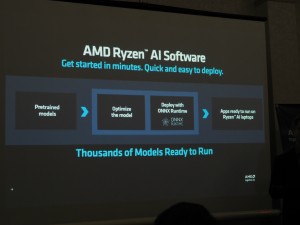

さらにAMDではクライアント向けのAIアプリケーションの開発を促進するため、x86 CPUでは初めてNPUを搭載したRyzen AI向けフレームワークとして「Ryzen AI software」を提供している。こちらはすでに次世代バージョンの開発も開始しており、CPU、GPU、NPUの最適化によりパフォーマンスは最大で3倍程度向上する予定ということだ。

|

|

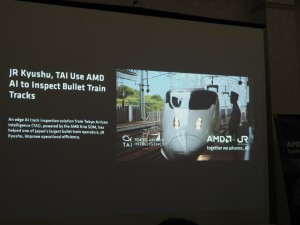

| AMDのAIデバイスの活用分野として、新幹線の線路検査システムや自動駐車システム等が挙げられていた | |

|

|

| イベント冒頭では日本AMD代表取締役社長Jon Robottom氏が登壇し、今後注力する分野を紹介した | |

文: 編集部 池西 樹

日本AMD株式会社: https://www.amd.com/ja.html