2018.05.31 18:35 更新

2018.05.29 配信

NVIDIAは人工知能(AI)やハイパフォーマンスコンピューティング(HPC)向けクラウドサーバープラットフォーム「HGX-2」を発表した。

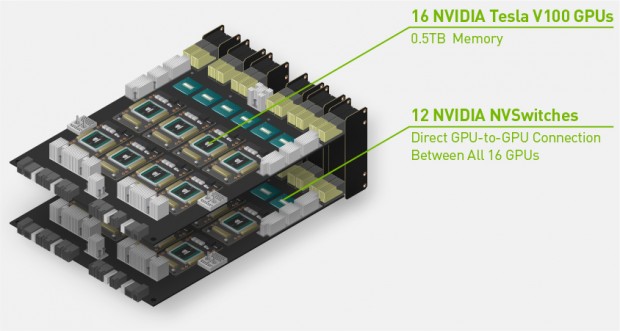

「HGX-2」は、NVIDIAの最新コアVolta採用GPU「Tesla V100」を8基搭載するメイン基板を2基連結。最大16基の「Tesla V100」は、12基のNVSwitchで接続されており、0.5TBメモリ、ディープラーニング処理性能2ペタFLOPSのGPUアクセラレータとして動作させることができる。

|

主なスペックは単精度処理性能が250テラFLOPS、倍精度演算処理性能が125テラFLOPS、CUDAコア数は81,920基、Tensorコア数が10,240基、NVLink帯域幅(NVSwitch)が2.4TB/sec。

|

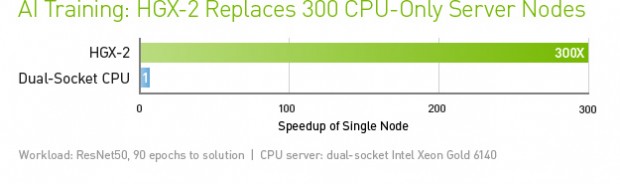

なおNVIDIAによれば、AI処理においてはCPUのみのサーバーと比較して最大300倍の処理性能を発揮することができ、データセンターの設置スペースやエネルギー効率を高め、コストを大幅に削減することができるとしている。

文: エルミタージュ秋葉原編集部 池西 樹

NVIDIA Corporation: http://www.nvidia.com/