2022.03.23 02:00 更新

2022.03.22 配信

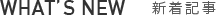

NVIDIA Corporation(本社:アメリカ・カリフォルニア州)は2022年3月22日(現地時間)、オンラインカンファレンス「GTC 2022」の基調講演において最新アーキテクチャ「Hopper」を採用する、データセンター向けGPU「NVIDIA H100」を発表した。

|

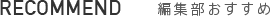

TSMCの4nmプロセスで製造され、Amperアーキテクチャを採用する「NVIDIA A100」の約1.5倍の800億のトランジスタを内蔵。大規模トレーニングのスループットは最大9倍、大規模言語モデルのインターフェイススループットは最大で30倍も向上しているという。

|

|

|

|

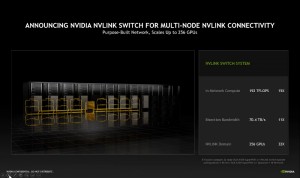

| 「NVIDIA H100」では演算性能だけでなく、接続インターフェイスも大幅に高速化され、大規模かつスケーラビリティに優れたシステムを構築できる | |

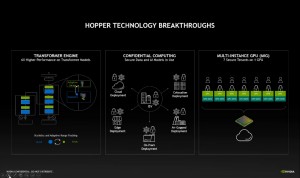

また新たに機械学習エンジンを内蔵したほか、クラウド上で利用データを暗号化する「Confidential Computing」や、1つのGPUで最大7つのインスタンスを利用することができる第2世代「Multi Instance GPU」機能を備える。

|

|

| ネットワークチップとPCI-Express5.0で接続された拡張カード型の「H100 CNX」や、NVIDIAのオリジナルCPUであるGRACEとの一体型モデルもラインナップ | |

演算性能はFP8が4,000TFLOPS、FP16が2,000TFLOPS、TF32が1,000TFLOPS、FP64が60TFLOPS、メモリはHBM3.0、メモリスピードは3TB/sec、インターフェイスはPCI-Express5.0(128GB/sec)と第4世代NVLink(900GB/sec)をサポートする。

|

|

|

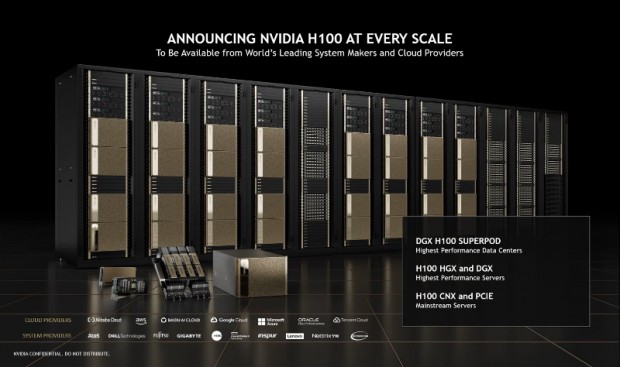

なおNVIDIAでは「NVIDIA H100」のシステムとして、SMXユニットの他、ConnectX-7とPCI-Express5.0で直接接続したメインストリームサーバー向けの拡張カード型「H100 CNX」や、8基の「NVIDIA H100」を搭載したハイエンドサーバー向け「NVIDIA DGX H100」、「NVIDIA DGX H100」をNVLink Switchを使い32基接続したエンタープライズデータセンター向け「DGX Super POD WITH DGX H100」を準備中。

さらに「DGX Super POD WITH DGX H100」を9台まとめたスーパーコンピューターシステム「NVIDIA EoS」についてもOEMやクラウドパートナー向けに提案しているとのこと

文: エルミタージュ秋葉原編集部 池西 樹

NVIDIA Corporation: http://www.nvidia.com/