2024.03.19 12:08 更新

2024.03.18 配信

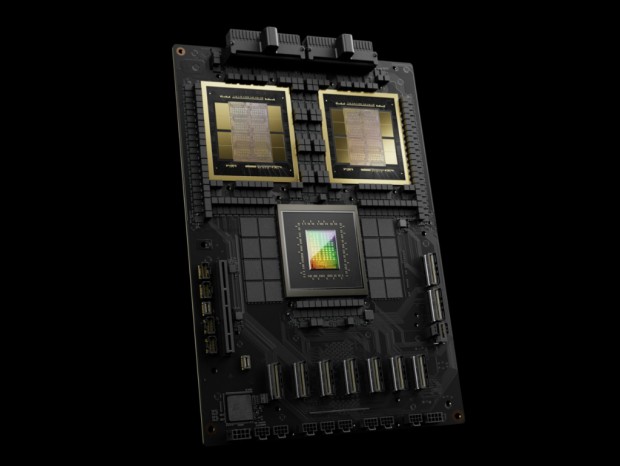

NVIDIA Corporation(本社:アメリカ・カリフォルニア州)は2024年3月18日(現地時間)、オンラインカンファレンス「GTC 2024」にてデータセンター向け「Blackwell」アーキテクチャを発表した。なお採用製品は2024年後半より順次販売が開始される予定。

2022年にリリースされた「Hopper」の後継モデルにあたる製品で、2つのGPUダイを10TB/sの超高速チップ間リンク技術で結合。さらに192GBのHBMeメモリを搭載し、トランジスタ数は2,080億、製造プロセスはTSMCのカスタム4NPを採用する。

さらに4bit浮動小数点AI推論機能に対応する第2世代Transformer Engineや、最大576基までのGPU接続に対応する第5世代NVLink、信頼性・可用性・保守性を高める専用エンジンRAS Engine、データベースクエリを高速化する「Decompression Engine」などの機能により、最大10兆パラメータのAIトレーニングやリアルタイムLLM推論処理に対応する。

|

| 2基のBlackwellチップとNVIDIA Grace CPUを組み合わせた「NVIDIA GB200 Grace Blackwell Superchip」 |

また「Blackwell」アーキテクチャを採用する製品として、2基のBlackwell GPUをNVIDIA Grace CPUに接続した「NVIDIA GB200 Grace Blackwell Superchip」(以下:GB200)や、36基の「GB200」を第5世代NVLinkで相互接続した水冷ラックシステム「NVIDIA GB200 NVL72」が用意されている。

|

| 「NVIDIA GB200 NVL72」には、36基の「NVIDIA GB200 Grace Blackwell Superchip」が収納されている |

ちなみにNVIDIAによれば「NVIDIA GB200 NVL72」は、同数の先代GPU「NVIDIA H100 Tensor GPU」で構成されるサーバーと比較して、LLM推論ワークロード性能は最大30倍、エネルキー効率は最大25倍と大幅に向上しているという。

|

| 最大576基のGPUを連結したスーパーコンピュータ「DGX SuperPOD」も公開された |

文: 編集部 池西 樹

NVIDIA Corporation: https://www.nvidia.com/